tg-me.com/nlp_stuff/326

Last Update:

مدل HuggingGPT، مدلی با مغز GPT و بازوی HuggingFace

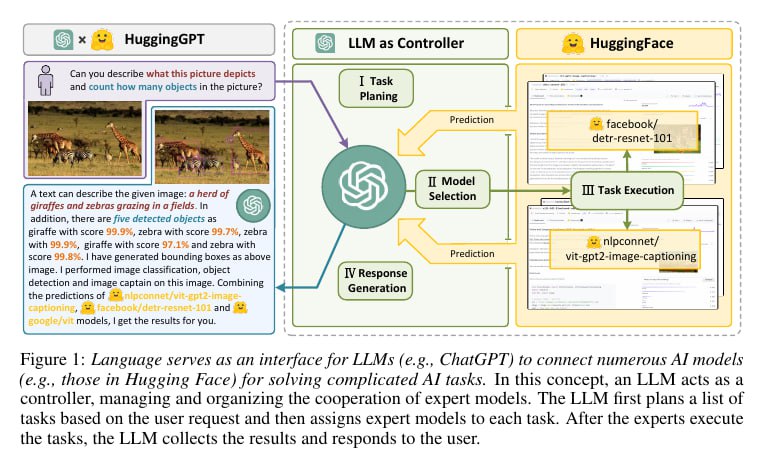

همانطور که خودتون هم میبینید و میشنوید ChatGPT همه جا رو در نوردیده و طیف مختلف و وسیعی از وظایف مختلف رو میتونه بهتر از انسان انجام بده. با وجود این همه قدرت مدلهای زبانی، اما این مدلها محدودیتهایی هم دارند. مثلا صرفا به مسائلی که ورودی و خروجیشون متنی هستند محدود هستند (ممکنه بگید GPT4 مدل مولتی موداله بله اما GPT4 اولا فقط میتونه در ورودی تصویر بگیره و ثانیا اگر بخواد تصویر خروجی بده باید تحت کدی مثل tikz این کار رو بکنه که کیفیت عکسهاش اصلا اون چیزی که در نظر هست نیست). محدودیت دیگه این که در سناریوهای دنیای واقعی که نیازمند شکستن وظیفه به چندزیروظیفه هست هم عملکرد کاملی ندارند و البته در بعضی مسائل خاص متنی هم حتی نسبت به مدلهای اکسپرت عملکرد پایینتری دارند. حالا یک عده چینی از دانشگاه zhejiang ایدهای برای حل این محدودیتها به سرشون زده و اون رو با نام HuggingGPT پیاده کردند. شهود این ایده این شکلیه که بیایم از chat-gpt به عنوان مغز و یک جور کنترلگر و از مدلهای حاضر در هاب هاگینگفیس در حکم بازوان اجرایی متخصص استفاده کنیم. در این صورت میتونیم هم از قدرت منطقی gpt استفاده کنیم و هم این که تسکهایی که gpt نمیتونه اجراشون کنه (مثل تسکهای تصویری و صوتی) رو با استفاده از مدلهای متخصص حاضر بر روی HuggingFace بتونیم انجام بدیم.

این مدل به صورت کلی چهار بخش Task Planning و Model Selection و Task Execution و Response Generation دارد. روال کار هم به این صورته که کاربر درخواستش رو به مدل میده و مدل طی یک پایپلاین با کمک این چهار بخش درخواست کاربر رو انجام میده. در Task Planning درخواست کاربر ورودی گرفته میشه و به ChatGPT داده میشه. در این جا chatgpt وظیفه داره منظور این درخواست کاربر رو بفهمه و اون رو به زیروظایف کوچکتر بشکنه و همچنین ترتیب اجرای این زیروظایف و ورودی و خروجی اونها رو مشخص کنه. در گام بعدی یا Model Selection سپس هر کدوم از این زیروظایف و مشخصات مدلهای حاضر بر روی هاب هاگینگفیس به chatgpt داده میشن و chatgpt تصمیم میگیره که برای هر یک از این زیروظایف از چه مدلی میشه استفاده کرد. سپس در مرحله سوم یا Task Execution، هر یک از این زیروظایف توسط مدلهای مشخص شده اجرا میشن و البته تحت ترتیبی که تو مرحله یک مشخص شده به هم وصل میشن و ورودی و خروجیهای همدیگر رو فراهم میکنند. در گام آخر یا Repsonse Generation هم دوباره خروجیهای مرحله سوم به ChatGPT داده میشن و ChatGPT با جمعبندی این خروجیها، خروجی نهایی مدل رو آماده میکنه. برای فهم بهتر میتونید تصاویر پیوست شده رو مشاهده کنید. یک سری آزمایش هم اومدند و روی این مدل انجام دادند و نشون دادند که میتونه وظایف خیلی پیچیدهای که نیازمند ترکیب تواناییهای تصویری و صوتی و متنی هست رو انجام بده. نکته واجب به ذکر اینه که برای این که ChatGPT بفهمه هر یک از مراحل بالا رو باید انجام بده هم از In-context Learning استفاده کردند، یعنی این که نمونه ورودیها و خروجیها رو در prompt ورودی به ChatGPT میدن و GPT خودش میفهمه باید چه جوری اوستا کنه قضیه رو.

قبلا در این پست (https://www.tg-me.com/us/NLP stuff/com.nlp_stuff/318) هم راجع به یک کیس جالب دیگه که از LLM به عنوان حتی بکاند استفاده کرده بود صحبت کرده بودیم. به نظر میرسه با قدرتگیری LLMها در آینده نزدیک شاهد خیزش ترندی خواهیم بود که سعی میشه تا از اونها در حکم LLM as App یا حتی LLM as Everything استفاده بشه. آینده جذابی پیش روی محصولات این حوزه است. کسی چه میداند، شاید دنیای مهندسی نرمافزار بعد از LLM ها به شدت تکانده شود.

لینک مقاله:

https://arxiv.org/abs/2303.17580

پینوشت: با به اشتراکگذاری مطالبی که از آنها لذت میبرید، به بقیه هم این لذت رو هدیه بدید.

#read

#paper

@nlp_stuff

BY NLP stuff

Share with your friend now:

tg-me.com/nlp_stuff/326