tg-me.com/nlp_stuff/172

Last Update:

اشتباه نکنید! مکانیزم توجه همه آن چیزی که لازم دارید نیست!

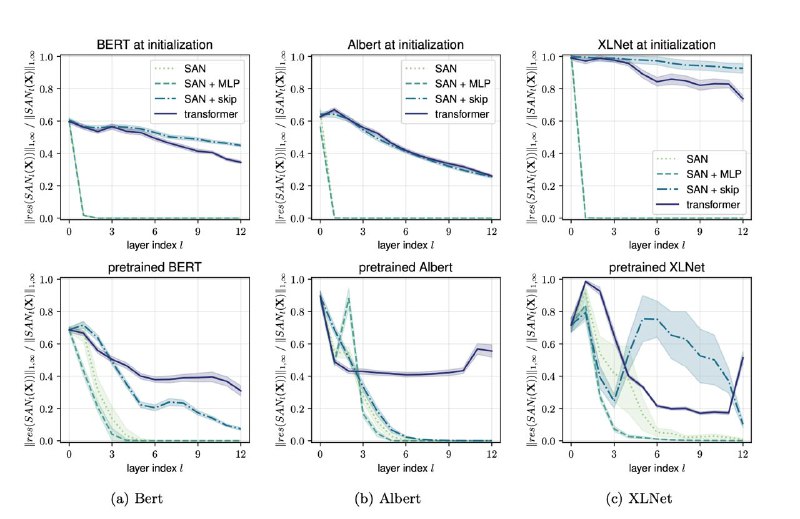

با ظهور و بروز هر چه بیشتر انواع معماریهای ترنسفورمری برای مودالیتیهای مختلف مانند متن و تصویر، این تصور ایجاد شده که واقعا مکانیزم توجه یه تنه داره بازی رو در میاره. اما بچههای EPFL به همراه یک تن از خوبای گوگل ترمز رو کشیدند و با محاسبات ریاضیاتی که انجام دادند، اثبات کردند که چنانچه مکانیزم توجه بدون حضور اسکیپکانکشنها و شبکه MLP به کار گرفته بشه، باعث میشه که شبکه ترنسفورمری در طول لایهها به سمت یک ماتریس با رنک ۱ همگرا بشه. در واقع اگر این دو مکانیزم نباشند هر چه به سمت لایههای بالاتر شبکه ترنسفورمر پیش بریم، شبکه با توکنهای ورودی به طور یکسان برخورد میکنه. در واقع این دوستان اثبات کردند که وجود اسکیپ کانکشن باعث میشه که رنک نهایی ماتریسی که لایههای شبکه ترنسفورمر به آن همگرا میشه بیشتر از یک باشه و شبکه با توکنهای ورودی بهطور متفاوت برخورد کنه و وجود MLP، همگرایی لایهها را به تعویق میندازه. همچنین این دوستان ثابت کردند که نرمالسازی لایهها که در معماری ترنسفورمر وجود داره هیچ نقشی رو ایفا نمیکنه! یافتههای این پژوهش بار دیگه اهمیت وجود اسکیپکانکشن ها رو اثبات میکنه و داره به ما میگه که شبکههای MLP رو هم اصلا دستکم نگیریم. این دوستان در نهایت یافتههای علمیشون رو بر روی سه معماری BERT و Albert و XLnet هم تست کردند که در تصویر زیر روند همگرایی این شبکهها رو در طول لایههای مختلف میتونید ببینید. همونطور که مشخصه معماریای که تنها مبتنی بر توجه به خود است با همگرایی سریع به سمت ماتریس با رنک یک مواجه میشه که باعث میشه که با همه توکنها به یک صورت برخورد کنه که اصلا چیز مطلوبی نیست.

لینک مقاله:

https://arxiv.org/abs/2103.03404

#paper

#read

@nlp_stuff

BY NLP stuff

Share with your friend now:

tg-me.com/nlp_stuff/172